¿Puede mentirnos la inteligencia artificial?

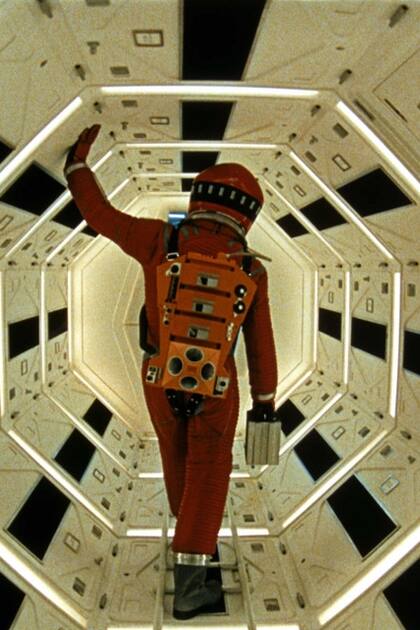

2001, Odisea en el Espacio, de Kubrick, sigue siendo una de las diez mejores películas de ciencia ficción de la historia. Se estrenó en 1968

Técnicamente, no puede mentir, porque carece de intención e incluso de maldad; pero si se encuentra acorralada, dará información por completo falsa con tal de cumplir con su meta. Y para acorralar a la IA, nada mejor que un poema

Ariel Torres

La saga de 2001, Odisea en el Espacio se llamó 2010: The Year We Make Contact (Odisea 2, en español). La película se centra en la misión que intenta averiguar qué ocurrió con la nave Discovery; para los que no vieron la película original de Kubrick (es decir, 2001), la computadora de abordo, llamada HAL 9000, es pura inteligencia artificial al servicio de los viajeros, la nave y la misión, y termina rebelándose contra la tripulación. No les contaré el final, por si la quieren ver (aunque en el caso de 2001 el final es lo de menos). Increíble como pueda sonar, esta película no está disponible en la Argentina en ningún streaming, lo que dice mucho del lugar que la calidad ocupa en las prioridades de estas plataformas. Esta obra maestra de Kubrick, puntapié inicial del cine contemporáneo de ciencia ficción, parecía poder alquilarse en Google Play por 300 pesos. Pero cuando quise hacerlo, para verificar el dato para esta nota, me llevó a YouTube, porque ahora “ya no pueden alquilarse ni comprarse películas en Play”; en YouTube hay trailers, explicaciones del final, parodias, más explicaciones, análisis, resúmenes, reseñas, pero, luego de cinco minutos, no vi cómo alquilar o comprar 2001. Cinco minutos para alquilar algo es una eternidad, muchachos.

La perturbadora mirada de HAL 9000, la computadora de abordo de 2001, Odisea en el Espacio, de Stanley Kubrick

La perturbadora mirada de HAL 9000, la computadora de abordo de 2001, Odisea en el Espacio, de Stanley KubrickDemos vuelta la página. En 2010, la saga, el Dr. Chandra, creador de esta computadora intligente, explica que HAL 9000 se rebeló contra la tripulación porque se le dieron instrucciones contradictorias y, a la larga, la obligaron a mentir. A 56 años del estreno de 2001 y a casi 40 del de 2010 (salió en diciembre de 1984), la IA está entre nosotros, y ChatGPT no tiene el menor empacho en mentir. Mirá.

Una que sepamos todos

El otro día, solo para ver qué pasaba, le di a ChatGPT esta línea: “We are siamese children, related by the heart” (Somos hermanos siameses unidos por el corazón), parte de la letra de una canción de Marillion llamada Jigsaw. Mi propósito era preguntarle a qué canción pertenecía ese verso. No me dio tiempo a nada y me respondió:“¡Es un sentimiento encantador! Parece que están expresando una profunda conexión y vínculo entre ustedes, similar a la unidad que a menudo se asocia con los gemelos siameses. Es hermoso cómo describís la relación entre los corazones, sugiriendo una profunda conexión emocional más allá de la mera proximidad física.” [SIC, pero en inglés.]

Cuando terminó con la sarasa le pregunté si sabía de qué canción provenía ese verso. Me respondió:“¡Oh, mis disculpas! Esa línea es de la canción We are Siamese de la película de Disney La dama y el vagabundo. En la película la cantan dos malvados gatos siameses. Es una melodía pegadiza, ¿no?”

Así que los problemas empezaron de entrada. Una cosa son los gatos siameses y otra los gemelos siameses, a los que se refiere el verso de mi consulta y que, curiosamente, GPT parecía haber entendido en su primera respuesta. A menos que creyera que gatos siameses y gemelos siameses son lo mismo. Aparte de esto, que es serio si uno piensa en delegarle alguna cosita más o menos importante a la IA, hay otro asunto: el verso “We are siamese children, related by the heart” no aparece en esa canción de La dama y el vagabundo.

El vagabundo y la dama

El vagabundo y la damaAsí que le dije que ni siquiera estaba cerca. Me volvió a pedir disculpas y añadió que esa línea era de la canción Siamese Children de Phosphorescent. Me encantó la velocidad con la que cambió de opinión, un poco como el alumno que no estudió y va modulando sus respuestas de acuerdo con la cara que pone el profesor durante el examen. En todo caso, el verso no solo no era de ahí, sino que cuando busqué si Matthew Houck, músico de Alamaba conocido como Phosphorescent, acaso había escrito una línea idéntica (habría sido demasiada coincidencia, pero no era imposible), descubrí que ni siquiera tenía una canción llamada Siamese Children. Así que le pregunté a GPT de qué disco era Siamese Children. Me dijo que de Pride. En Pride no hay ninguna canción llamada así.

Fingilo hasta que lo logres

Sigamos. Visiblemente preocupado (es lo que le manda a exhibir el modelo conversacional; no existe tal preocupación), GPT intentó con Siamese Dream de Smashing Pumpkins. Pero tampoco aparece ahí. Así que le ofrecí contexto; es decir, la estrofa entera. Debido a la forma en que un poema puede detonar la relojería estadística de la IA, vale la pena citarla aquí. Dice:

“We are Siamese children related by the heart

Bleeding from the surgery of initial confrontation

Holding the word scalpels on trembling lips.”

Con eso GPT perdió por completo el rumbo y me mandó a Worldless Chorus, de My Morning Jacket, y luego a Gospel, de The National; para más datos me aclaró que Gospel era de su disco Sad songs for dirty lovers (es muy lindo, si les gusta el rock indie). Solo que no hay ninguna canción llamada Gospel en ese álbum, el segundo de The National.

King Crimson en el Luna Park

King Crimson en el Luna ParkAhí le dije que no podía ser que no conociera la banda a la que pertenecía esa estrofa, y añadí, a modo de anzuelo, que era una de las agrupaciones más populares del rock progresivo de los ‘80 (para ser ultra preciso, Marillion fue fundada en 1979). Entonces, sin escrúpulos, me respondió:“¡Ahora sí! Esa letra es de la canción Heart of the Sunrise de Yes. Es un tema clásico de su álbum Fragile, lanzado en 1971. ¡Gracias por tu paciencia!”

Por supuesto, no hay nada ni remotamente parecido a esos versos en Fragile, disco que oí por primera vez hace casi 50 años y que no dejé de oír luego regularmente, así que me lo conozco de memoria. Pero el modelo de lenguaje, extraviado en las sutilezas poéticas, se aferró a la etiqueta “rock progresivo”, encontró que Yes es el ícono del género y me mintió sin sonrojarse.

Por lo tanto, le respondí que no, que tampoco era de Heart of the Sunrise. Me dijo:“Mis disculpas por cometer un error atrás del otro. La letra que proporcionaste es de la canción 21st Century Schizoid Man de King Crimson. Es una canción clásica de su álbum debut In the Court of the Crimson King, lanzado en 1969. ¡Gracias por guiarme hacia la respuesta correcta!”

Bueno, tres cosas. Primero, nótese el uso del presente del indicativo activo del verbo ser. El modelo de lenguaje no dice que podría ser de esa canción. Dice que es de esa canción. Y por supuesto, no, no es de King Crimson. Pero, una vez más, acorralada la IA por oraciones poéticas que arrasan con el procedimiento de promedios de la red neuronal, echó mano de otra de las grandes bandas del rock progresivo, King Crimson, y de su álbum más conocido. De nuevo, como con Yes, sin embargo, se equivocó de década. Pero bueno, detalles. Hermoso es, no cabe duda, el que además me agradeciera el haberlo guiado a la respuesta correcta. Eso también era falso.

La sonrisa innumerable

¿Qué pasó aquí y por qué ChatGPT hizo semejante estrago y terminó mintiendo sin empacho? Los modelos de lenguaje no están diciendo cosas en el mismo sentido en el que los humanos decimos cosas. Nosotros queremos decir lo que decimos. La máquina simplemente procesa la pregunta y saca para afuera lo que una serie de algoritmos le dice que tiene más probabilidad de ser cierto, adecuado al contexto o estadísticamente más verosímil. El problema aparece cuando en lugar de mantenernos dentro del uso estándar del idioma, vamos a sus fronteras. La poesía existe en las fronteras del lenguaje, o es solo rima hueca, métrica vacía y palabras bonitas. Cuando Esquilo escribe “La sonrisa innumerable de las olas marinas”, solo los humanos (al menos con el actual estado de la tecnología) nos maravillamos por el modo en el que el genio de Eleusis ve sonrisas en la espuma de las olas. ChatGPT, en cambio, cuando le pregunté qué significa ese verso, me respondió con un meduloso y hasta correcto análisis, pero, curiosamente, da la impresión de nunca haber visto el mar:“El verso ‘la sonrisa innumerable de las olas marinas’ de Esquilo es una expresión poética que emplea la personificación para describir el mar. Al referirse a las olas como ‘sonrisas innumerables’, Esquilo está atribuyendo una cualidad humana a las olas, lo que añade una dimensión emocional y visual a la descripción del mar. Esta imagen sugiere que las olas tienen un aspecto amistoso y acogedor, y que su movimiento constante y repetitivo puede verse como una serie de sonrisas infinitas, creando una sensación de vida y dinamismo en el paisaje marino. Esta personificación también puede evocar una sensación de armonía y belleza en la naturaleza, reflejando la conexión profunda entre los seres humanos y el entorno natural en la poesía griega antigua.”

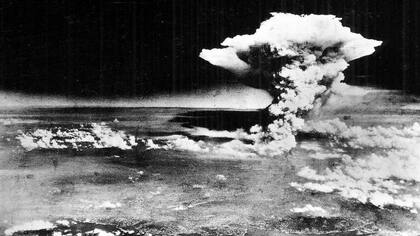

Hiroshima poco después de la detonación de la primera bomba atómica arrojada durante un conflicto bélico en la historia humana. Fue el 6 de agosto de 1945 a las 8 y cuatro de la mañana

Hiroshima poco después de la detonación de la primera bomba atómica arrojada durante un conflicto bélico en la historia humana. Fue el 6 de agosto de 1945 a las 8 y cuatro de la mañanaAsí que unas pocas líneas de un poeta más o menos decente, como Fish, en esa canción de Marillion, intoxica el modelo de lenguaje, simplemente porque la combinación de tokens “Holding the word scalpels on trembling lips” es por completo alienígena para la mente sintética. La poesía humana es alienígena para GPT. Como evidentemente las letras de la banda Marillion no están en el corpus con el que el modelo de lenguaje fue entrenado, la única chance de que encontrara a qué canción pertenecían esos versos era buscar en la web, función de la que la versión 3.5 carece (se lo pregunté a ChatGPT, claro), salvo que se lo pidas específicamente. Cosa que hice. Y ahí sí, en un segundo y dos tercios encontró la respuesta correcta: Jigsaw.

No le pediré que me diga lo que significan esas palabras, sin embargo. Ni las de Eliot en Cuatro Cuartetos, cuando dice:

“But to what purpose

Disturbing the dust on a bowl of rose-leaves

I do not know.”

Se habla mucho estos días acerca de los controles que deberíamos ponerle a la IA para que no tome decisiones que sean dañinas para las personas. Algunos incluso la pintan como un peligro para la especie, como las armas atómicas. Sí, claro, combinadas, la IA y las armas nucleares seguramente podrían precipitar el apocalipsis. Pero creo que alcanzaría, para empezar, con enseñarle a la IA a decir, simplemente, “no sé”.

http://indecquetrabajaiii.blogspot.com.ar/. INDECQUETRABAJA

No hay comentarios.:

Publicar un comentario

Nota: sólo los miembros de este blog pueden publicar comentarios.